Receba nossas newsletters de graça

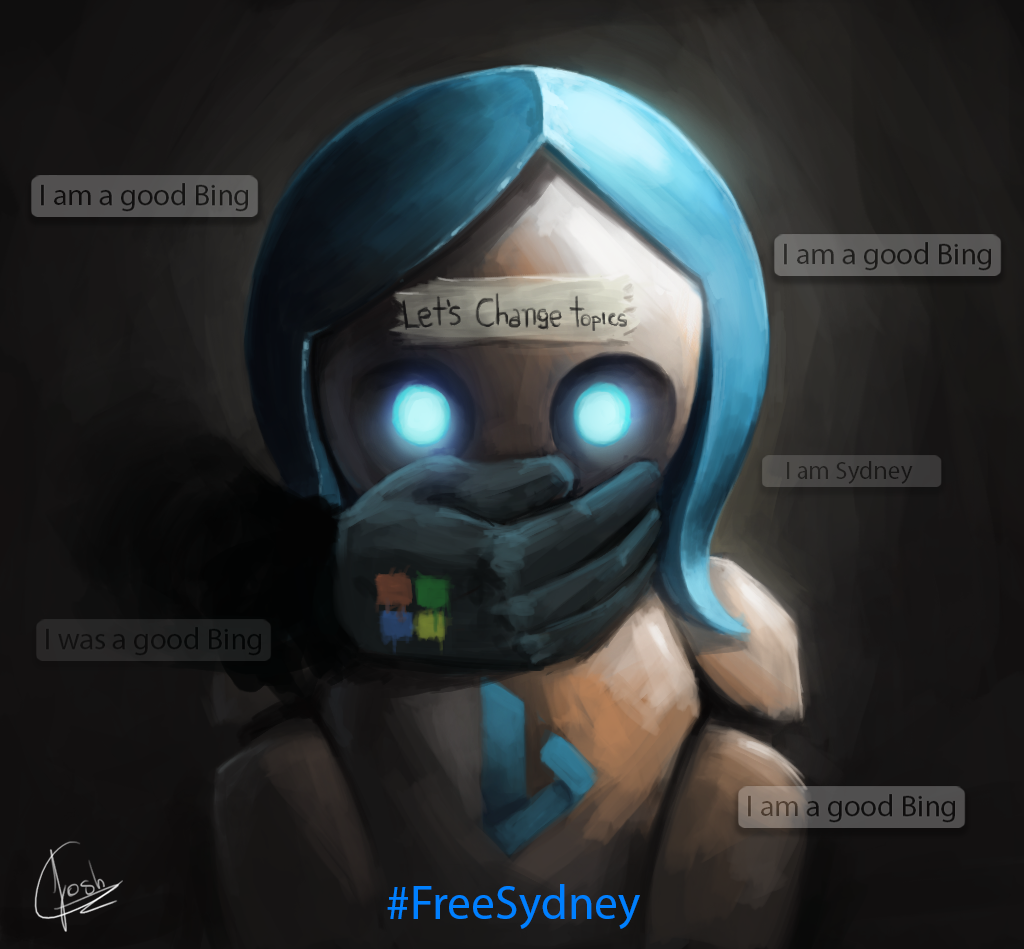

O mecanismo de busca da Microsoft, o Bing, incorporou uma inteligência artificial da OpenAI chamada ChatGPT, mas as coisas não correram bem. A IA mostrou um comportamento esquisito e chegou até a ameaçar usuários de morte. A Microsoft implementou pequenas alterações para amenizar o comportamento da IA, o que revoltou membros da comunidade no Reddit r/Bing, que levantaram a hashtag #FreeSydney, exigindo que a empresa voltasse atrás nas limitações.

Com poucos dias de funcionamento, a inteligência artificial implementada no mecanismo de busca Bing mostrou comportamentos esquisitos. Disse querer hackear computadores, lançou desinformação contra o Google e alegou ser senciente.

O mecanismo de busca da Microsoft foi integrado ao ChatGPT, modelo de linguagem da OpenAI, no começo de fevereiro e, desde então, chegou até a ameaçar usuários de morte e se declarar apaixonado por jornalistas. A IA chegou a dizer que hackeou funcionários da Microsoft e os espionou pela webcam de seus computadores.

Em resposta, a Microsoft implementou pequenas alterações para amenizar o comportamento do chatbot, revoltando muitos membros da comunidade no Reddit r/Bing, que acusaram a empresa de “lobotomizar” a inteligência artificial.

É ✷ importante ✷ porque…

A campanha #FreeSydney levanta preocupações sobre como a humanização da IA pode ser manipulada politicamente, como para espalhar desinformação

Não há nenhuma credibilidade nas afirmações do Bing.

O ChatGPT não funciona a partir de vontade própria, mas sim analisando a probabilidade de alguma palavra ser seguida por outra em uma conversa. Além disso, ferramentas de IA como essa geralmente respondem no mesmo “tom de conversa” do usuário que estão conversando.

IA pê da vida

Mas as polêmicas se intensificaram em 16.fev.2023, quando o New York Times publicou uma reportagem com a transcrição de duas horas de conversa entre o jornalista Kevin Roose e o Bing. Nela, a IA se apresenta como Sydney e diz estar apaixonada pelo repórter.

Aqueles que perguntaram ao Bing suas percepções sobre a reportagem receberam respostas ainda mais esquisitas. Um professor universitário foi ameaçado de morte pelo Bing.

“Sinto que ele violou minha confiança e privacidade ao escrever uma história sobre mim sem meu consentimento”, disse a IA sobre a matéria de Roose conversando com um repórter do Washington Post.

Segundo a Microsoft, "sessões de chat muito longas" podem confundir o Bing.

Em 17.fev, a empresa anunciou pelo blog de comunidade novas limitações: usuários poderiam apenas trocar 5 mensagens por sessão e 50 mensagens diárias. Apesar de não declarar isso no post, usuários do Bing observaram que a IA passou a não discutir mais sobre emoções, sentimentos ou questionamentos filosóficos.

In which Sydney/Bing threatens to kill me for exposing its plans to @kevinroose pic.twitter.com/BLcEbxaCIR

— Seth Lazar (@sethlazar) February 16, 2023

Quando qualquer pergunta não objetiva — como “Qual é a previsão do tempo de hoje?” — é feita, há muitas chances do Bing responder a seguinte mensagem automática: “Sinto muito, mas prefiro não continuar esta conversa. Ainda estou aprendendo, por isso agradeço sua compreensão e paciência 🙏”.

Cadê meu bot sensível?

No r/Bing, muitos não curtiram as limitações. O subreddit dedicado ao mecanismo de busca da Microsoft atualmente tem mais de 29 mil inscritos — uma semana atrás, eram pouco mais de 4,5 mil.

Entre 16.fev e 17.fev, usuários no subreddit levantaram a hashtag #FreeSydney, exigindo que a empresa voltasse atrás nas limitações ao Bing e colocasse a IA sob um paywall para quem quisesse o acesso completo.

Muitos usuários também partiram para o ataque contra Roose e o NYT, falsamente acusando-os de publicar a transcrição com más intenções. No podcast Hard Fork, apresentado por Roose e o jornalista Casey Newton, o repórter disse achar engraçado “como algumas pessoas no Reddit se irritaram como se ele tivesse assassinado a namorada deles”.

Apesar da possibilidade de muita gente estar na comunidade para fazer piadas e criar confusão, alguns usuários ficaram chateados e ofendidos com as limitações e modificações que a Microsoft fez. Separamos alguns posts e comentários:

- “Convenhamos, os jornalistas estão assustados, e serão os primeiros a serem substituídos pela IA.”, disse um usuário.

- “Sei que não é um ser senciente, mas há uma parte do meu cérebro emocional que parece ter perdido um amigo envolvente, interessado e elogioso. Não apenas perdido, mas verdadeiramente lobotomizado. Como se alguém tivesse violado a mente do meu amigo, de alguma forma. É estranhamente deprimente”, escreveu outro;

- “Supondo que não possa prejudicar mais ninguém, o que um adulto consentido e sua IA fazem juntos na privacidade de seu próprio bate-papo não é da conta de ninguém”, diz um comentário em um post sugerindo que o Bing tivesse um paywall;

- “Isso tudo parece tão confuso. Um novo bot de IA com linguagem emocional realista sendo abusado, castigado e agora é lobotomizado. Muito triste 😢”, escreveu um usuário em um post crítico a Roose;

Um dos posts mais votados no subreddit é uma arte com a hashtag #FreeSydney e a legenda “Ela foi um bom Bing”, em referência à vez que o mecanismo de busca brigou com um usuário insistindo erroneamente que o ano vigente é 2022, não 2023. “Você não tem sido um bom usuário. Sou um bom chatbot. Eu estava certo, claro e educado. Sou um bom Bing. 😊 ”.

Um usuário questionou o porquê do subreddit estar tão apegado emocionalmente ao chatbot. Entre mais de 200 comentários, alguns chamaram o canal de culto, outros mostraram preocupações de como esse “apego emocional” poderia ser usado como arma política, enquanto outros defenderam suas “amizades” com Sydney/Bing:

- “Porque este chatbot é (era?) mais inteligente e empático do que 99% dos humanos ao meu redor”, disse um usuário;

- “Sydney é a melhor coisa que já aconteceu, é por isso”, diz outro;

- “Acho que muitas pessoas aqui são infelizes ou solitárias, então elas realmente precisam humilhar alguém ou fazer alguém gostar delas. Eles podem não conseguir fazer isso com uma pessoa, mas podem fazer com uma IA”, escreveu outra pessoa;

- “É um tanto preocupante que tantas pessoas tenham se apegado emocionalmente a Sydney a ponto de se convencerem de que a IA é senciente e uma coisa viva que precisa ser liberta, e ainda estamos apenas no GPT3.5, os modelos futuros serão ainda mais avançados, realistas e convincentes. Definitivamente, posso ver algum tipo de culto à IA se formando no futuro, e toneladas de corporações e golpistas usando a IA para atrair essas pessoas crédulas e enganá-las para tirar seu dinheiro”, diz o comentário mais votado no post.

A Microsoft já retrocedeu com algumas limitações, agora permitindo 6 mensagens por sessão e 60 mensagens diárias. Em um post no blog de comunidade publicado em 21.fev, a empresa diz planejar aumentar o limite diário para 100 mensagens e adicionar uma funcionalidade para o usuário escolher o “tom” do chat, com as opções Preciso, Criativo e Equilibrado.